- Statystyczna kontrola procesu

- SQC a SPC

- Czym jest projektowanie eksperymentów (DOE)?

- Analiza wariancji (ANOVA)

Metody statystyczne w poprawie jakości

Wykorzystanie metod statystycznych w poprawie jakości przybiera wiele form, w tym:

Testowanie hipotez

Oceniane są dwie hipotezy: hipoteza zerowa (H0) i hipoteza alternatywna (H 1). Hipoteza zerowa to „słomiany człowiek” używany w teście statystycznym. Wnioskiem jest odrzucenie lub brak odrzucenia hipotezy zerowej.

Analiza regresji

Określa wyrażenie matematyczne opisujące zależność funkcjonalną między jedną odpowiedzią a jedną lub większą liczbą zmiennych niezależnych.

Statystyczna kontrola procesu (SPC)

Monitoruje, kontroluje i usprawnia procesy za pomocą technik statystycznych. SPC identyfikuje, kiedy procesy wymykają się spod kontroli ze względu na zmienność spowodowaną szczególnymi przyczynami (zmienność spowodowana szczególnymi okolicznościami, a nie nieodłącznie związana z procesem). Praktycy mogą następnie szukać sposobów na usunięcie tej zmienności z procesu.

Projektowanie i analiza eksperymenty

Planowanie, przeprowadzanie, analizowanie i interpretowanie kontrolowanych testów w celu oceny czynników, które mogą wpływać na zmienną odpowiedzi.

Praktyka wykorzystywania małej, reprezentatywnej próbki do wnioskowania o szerszej populacji powstała na początku XX wieku. William S. Gosset, bardziej znany pod pseudonimem „Student”, musiał pobrać małe próbki z procesu warzenia piwa, aby zrozumieć określone cechy jakościowe. Opracowane przez niego podejście statystyczne (obecnie nazywane testem t dla jednej próby) zostało następnie rozwinięte przez R. A. Fishera i innych.

Jerzy Neyman i E. S. Pearson opracowali bardziej kompletne ramy matematyczne dla testowania hipotez w latach dwudziestych XX wieku. Obejmowały one koncepcje znane obecnie statystykom, takie jak:

- Błąd typu I – nieprawidłowe odrzucenie hipotezy zerowej.

- Błąd typu II – nieprawidłowe odrzucenie hipotezy zerowej.

- Moc statystyczna – prawdopodobieństwo prawidłowego odrzucenia hipotezy zerowej.

Procedura analizy wariancji Fishera (lub ANOVA) zapewnia mechanizm statystyczny, za pomocą którego przeprowadza się wiele analiz statystycznych, takich jak badania powtarzalności i odtwarzalności przyrządów pomiarowych oraz inne zaprojektowane eksperymenty. ANOVA okazała się bardzo pomocnym narzędziem do określenia, w jaki sposób zmienność może być przypisana do pewnych rozważanych czynników.

W. Edwards Deming i inni krytykowali bezkrytyczne stosowanie procedur wnioskowania statystycznego, zauważając, że można wyciągnąć błędne wnioski, chyba że pobiera się próbki ze stabilnego systemu. Rozważenie rodzaju przeprowadzanego badania statystycznego powinno być kluczową kwestią przy analizowaniu danych.

Pobierz nasz e-book

Pobierz nasz bezpłatny e-book, aby dowiedzieć się, jak GQ Interim może przekształcić Twoją firmę dzięki specjalistycznym rozwiązaniom w zakresie przywództwa!

Statystyczna kontrola procesu

Procedury statystycznej kontroli procesu (SPC) mogą pomóc w monitorowaniu zachowania procesu.

Prawdopodobnie najbardziej udanym narzędziem SPC jest wykres kontrolny, pierwotnie opracowany przez Waltera Shewharta na początku lat dwudziestych XX wieku. Wykres kontrolny pomaga rejestrować dane i pozwala zobaczyć, kiedy wystąpi nietypowe zdarzenie, np. bardzo wysoka lub niska obserwacja w porównaniu z „typową” wydajnością procesu.

Wykresy kontrolne próbują rozróżnić dwa rodzaje zmienności procesu:

- Zmienność wynikająca ze wspólnej przyczyny, która jest nieodłącznie związana z procesem i zawsze będzie obecna.

- Specjalna przyczyna zmienności, która pochodzi ze źródeł zewnętrznych i wskazuje, że proces jest poza kontrolą statystyczną.

Różne testy mogą pomóc określić, kiedy wystąpiło zdarzenie wymykające się spod kontroli. Jednak wraz ze wzrostem liczby testów wzrasta również prawdopodobieństwo fałszywego alarmu.

Kontekst

Znaczny wzrost wykorzystania kart kontrolnych nastąpił podczas II wojny światowej w Stanach Zjednoczonych w celu zapewnienia jakości amunicji i innych strategicznie ważnych produktów. Wykorzystanie SPC zmniejszyło się nieco po wojnie, ale zostało następnie podjęte z wielkim skutkiem w Japonii i trwa do dnia dzisiejszego.

Wiele technik SPC zostało „odkrytych na nowo” przez amerykańskie firmy w ostatnich latach, zwłaszcza jako element inicjatyw poprawy jakości, takich jak Six Sigma. Powszechne stosowanie procedur tworzenia wykresów kontrolnych zostało znacznie ułatwione dzięki pakietom oprogramowania statystycznego i coraz bardziej zaawansowanym systemom gromadzenia danych.

Z czasem opracowano inne narzędzia do monitorowania procesów, w tym:

- Wykresy sumy skumulowanej (CUSUM): Rzędna każdego wykreślonego punktu reprezentuje sumę algebraiczną poprzedniej rzędnej i ostatnich odchyleń od celu.

- Wykresy wykładniczo ważonej średniej kroczącej (EWMA): Każdy punkt wykresu reprezentuje średnią ważoną bieżących i wszystkich poprzednich wartości podgrup, nadając większą wagę najnowszej historii procesu i zmniejszając wagę starszych danych.

Niedawno inni zalecili integrację SPC z narzędziami inżynieryjnej kontroli procesu (EPC), które regularnie zmieniają dane wejściowe procesu w celu poprawy wydajności.

Statystyczna kontrola jakości a statystyczna kontrola procesu (SQC vs. SPC)

W 1974 roku dr Kaoru Ishikawa zebrał zbiór narzędzi doskonalenia procesów w swoim tekście Guide to Quality Control. Są one znane na całym świecie jako siedem narzędzi kontroli jakości (7- QC):

- Analiza przyczynowo-skutkowa

- Arkusze kontrolne/liczebne

- Wykresy kontrolne

- Wykresy

- Histogramy

- Analiza Pareto

- Analiza rozproszenia

Oprócz podstawowych narzędzi 7-QC, istnieją również dodatkowe narzędzia znane jako siedem narzędzi uzupełniających (7- SUPP):

- Stratyfikacja danych

- Mapy defektów

- Dzienniki zdarzeń

- Schematy/mapy przepływu procesów

- Centra postępu

- Randomizacja

- Określenie wielkości próby

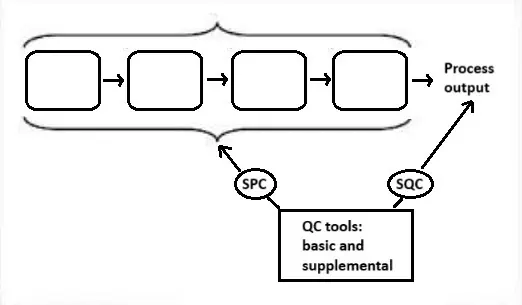

Statystyczna kontrola jakości (SQC) to zastosowanie 14 narzędzi statystycznych i analitycznych (7-QC i 7 SUPP) do monitorowania wyników procesu (zmiennych zależnych). Statystyczna kontrola procesu (SPC) to zastosowanie tych samych 14 narzędzi do kontrolowania danych wejściowych procesu (zmiennych niezależnych).

Poniższy rysunek przedstawia te zależności.

Czym jest projektowanie eksperymentów (DOE)?

Ta gałąź statystyki stosowanej zajmuje się planowaniem, przeprowadzaniem, analizowaniem i interpretowaniem kontrolowanych testów w celu oceny czynników kontrolujących wartość parametru lub grupy parametrów.

Strategicznie zaplanowany i przeprowadzony eksperyment może dostarczyć wielu informacji na temat wpływu jednego lub więcej czynników na zmienną odpowiedzi. Wiele eksperymentów polega na utrzymywaniu pewnych czynników na stałym poziomie i zmianie poziomów innej zmiennej. Takie podejście do wiedzy o procesach oparte na jednym czynniku w danym czasie (lub OFAT ) jest jednak nieefektywne w porównaniu ze zmianą poziomów czynników jednocześnie.

Wiele z obecnych podejść statystycznych do projektowanych eksperymentów wywodzi się z pracy R. A. Fishera z początku XX wieku. Fisher wykazał, że poświęcenie czasu na poważne rozważenie projektu i wykonania eksperymentu przed jego wypróbowaniem pomogło uniknąć często napotykanych problemów w analizie. Kluczowe pojęcia w tworzeniu zaprojektowanego eksperymentu obejmują blokowanie, randomizację i replikację.

Dobrze przeprowadzony eksperyment może dostarczyć odpowiedzi na pytania takie jak:

- Jakie są kluczowe czynniki w procesie?

- Przy jakich ustawieniach proces zapewnia akceptowalną wydajność?

- Jakie są kluczowe, główne i interakcyjne efekty tego procesu?

- Jakie ustawienia spowodowałyby mniejszą zmienność wyników?

Zachęcamy do powtarzalnego podejścia do zdobywania wiedzy, zazwyczaj obejmującego następujące po sobie kroki:

- Projekt przesiewowy, który zawęża pole ocenianych zmiennych.

- Projekt „w pełni czynnikowy”, który bada reakcję każdej kombinacji czynników i poziomów czynników oraz próbę określenia obszaru wartości, w którym proces jest bliski optymalizacji.

- Projekt powierzchni odpowiedzi do modelowania odpowiedzi.

Blokowanie

Gdy randomizacja czynnika jest niemożliwa lub zbyt kosztowna, blokowanie pozwala ograniczyć randomizację poprzez przeprowadzenie wszystkich prób z jednym ustawieniem czynnika, a następnie wszystkich prób z drugim ustawieniem.

Randomizacja

Odnosi się do kolejności, w jakiej wykonywane są próby eksperymentu. Losowa kolejność pomaga wyeliminować wpływ nieznanych lub niekontrolowanych zmiennych.

Replikacja

Powtórzenie pełnego leczenia eksperymentalnego, w tym konfiguracji.

Analiza wariancji (ANOVA)

ANOVA to podstawowa technika statystyczna służąca do określania proporcji wpływu czynnika lub zestawu czynników na całkowitą zmienność. Dzieli całkowitą zmienność zbioru danych na znaczące części składowe związane z określonymi źródłami zmienności w celu przetestowania hipotezy dotyczącej parametrów modelu lub oszacowania składników wariancji. Istnieją trzy modele: stały, losowy i mieszany.

Wnioski

Podsumowując, metody statystyczne stanowią podstawę skutecznej poprawy jakości. Narzędzia takie jak testowanie hipotez, analiza regresji, SPC i projektowanie eksperymentów umożliwiają organizacjom odkrywanie spostrzeżeń, monitorowanie wydajności i kontrolowanie zmienności. Poprzez rozróżnianie przyczyn powszechnych i szczególnych, optymalizację danych wejściowych procesu i systematyczne testowanie zmian, techniki te umożliwiają decydentom poprawę wyników, ograniczenie marnotrawstwa i zwiększenie ogólnej wydajności. Zastosowanie tych metod wspiera kulturę ciągłego doskonalenia opartą na danych i naukowym myśleniu.

Jesteś zainteresowany interim expert?

Odkryj, jak zarządzanie interim może radykalnie zwiększyć wydajność Twojej firmy. Skontaktuj się z naszym zespołem, aby dowiedzieć się, w jaki sposób współpraca z GQ Interim usprawni działanie Twojej firmy.

- Rozpocznij pracę w ciągu kilku dni

- Baza danych ponad 10 000 konsultantów

- Rozwiązywanie kluczowych problemów biznesowych

- Rozwiązania dostosowane do potrzeb biznesowych

- Sprawdzone wyniki o wymiernym wpływie

Powiązane artykuły

- Przykład zrównoważonej karty wyników pokazuje, w jaki sposób organizacje mogą mierzyć więcej niż tylko wyniki finansowe. Opracowana przez Roberta Kaplana i Davida Nortona zrównoważona karta wyników śledzi cele w zakresie finansów, klientów, procesów wewnętrznych oraz nauki i rozwoju. Dostosowując te perspektywy, zapewnia, że codzienne operacje wspierają długoterminową strategię i zrównoważony wzrost.

- Teoria Ograniczeń (Theory of Constraints - TOC) to ustrukturyzowane podejście do poprawy wydajności organizacyjnej poprzez skupienie się na pojedynczym, najbardziej ograniczającym czynniku - ograniczeniu. Niezależnie od tego, czy jest to wąskie gardło produkcyjne, popyt rynkowy czy luka w konwersji sprzedaży, TOC odpowiada na trzy podstawowe pytania - co zmienić, co zmienić i jak spowodować zmianę - i napędza ciągłe doskonalenie poprzez pięć zdyscyplinowanych kroków: identyfikacja, wykorzystanie, podporządkowanie, podniesienie i powtórzenie.

- Kontrola jakości oprogramowania gwarantuje, że oprogramowanie konsekwentnie spełnia potrzeby interesariuszy poprzez zapobieganie defektom i sprawdzanie, czy produkty są zgodne ze zdefiniowanymi atrybutami jakości (np. niezawodność, bezpieczeństwo, wydajność). Połączenie praktyk zarządzania defektami z opartymi na standardach modelami jakości, takimi jak ISO/IEC 25010, pomaga zespołom planować, mierzyć i stale poprawiać jakość w całym cyklu życia.

- W naszej pracy bardzo często spotykamy się z wieloma symbolami i skrótami np. FMEA, PPAP, CC, SC itp. Kiedy przeprowadzałem swój pierwszy audyt wewnętrzny w pracy, musiałem również sprawdzić wdrożenie oznaczenia CE. Wcześniej sprawdziłem, co to jest oznakowanie CE, aby nie być całkowicie zagubionym w tym obszarze. Więc co to jest i jak jest używane?